如何解决AWS S3对象存储上传限速问题

立即行动,享受优惠

现在下单即可享受限时优惠折扣,还有专业技术团队为您提供7*24小时服务支持。

1. 解决方案一:利用AWS S3的批量上传API提升效率

复制粘贴或逐个上传数据效率极低。 解决方案: 使用AWS S3的Batch API for Python或AWS CLI工具,可以一次性上传多个文件。 步骤:

- 创建一个批量上传的目标桶。

- 使用代码或命令将所有文件打包到一个对象。

- 调用Batch API上传这些对象。

这样,你可以将低效的逐个上传替换为高效的批量处理,节省大量时间。

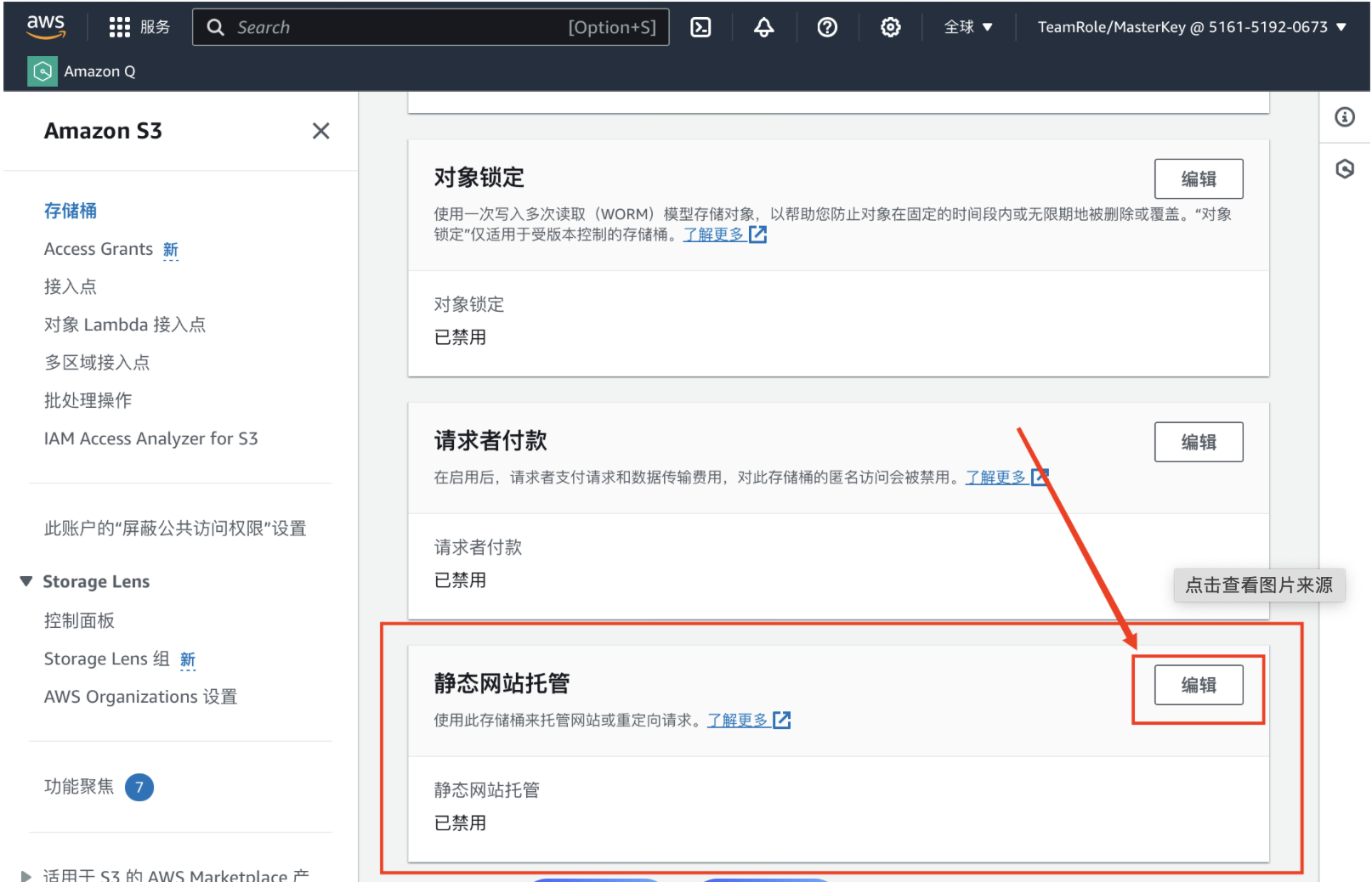

2. 解决方案二:优化S3 bucket的配置以减少延迟

痛点:目标桶的设置不当会导致上传速度变慢。 解决方案:

bucket policy,确保只有授权用户可以上传。- 使用

bucket retention policy,避免不必要的数据存储,减少磁盘I/O压力。 - 将桶设置为

spot allowed,利用云spot实例的高带宽和低延迟特性。

这些优化措施能有效提升上传速度,减少资源浪费。

3. 解决方案三:创建优化化的目标桶

痛点:使用原始桶会导致上传效率低下。 解决方案:

- 将目标数据集迁移到一个优化化的目标桶。

- 配置桶的

Bucket Public Read和Bucket ACL权限,确保只有需要的人才能访问。 - 使用

S3 Optimized Buckets,AWS会自动存储配置以提升性能。

这样,目标数据可以在专用桶中以更快的速度上传。

4. 解决方案四:使用第三方工具加速上传

痛点:手动操作或手动工具效率有限。 解决方案:

- 使用

S3 Command Line工具,编写脚本来自动化上传流程。 - 部署

AWS CLI,通过命令行工具完成批量上传任务。 - 使用

Python SDK,编写自动化代码来处理大量文件。

这些工具能够将繁琐的上传流程自动化,节省大量时间。

5. 解决方案五:监控和优化S3资源使用情况

痛点:资源使用不均衡可能导致性能瓶颈。 解决方案:

- 使用AWS CloudWatch来监控S3的IOPS(I/O操作数)和带宽使用情况。

- 根据监控结果,动态目标桶的存储和复制策略。

- 避免在高峰时段进行大量上传,合理规划资源使用时间。

通过这些监控措施,你可以更好地管理资源,提升上传效率。

问答部分:

用户问题1:如何快速解决S3上传速度慢的问题?

- 解决方案: 使用

AWS S3的Batch API将多个文件一次性上传,避免逐个处理。例如,通过aws s3 batch命令,将数百个文件打包上传,显著提升效率。

用户问题2:有哪些工具可以加速S3上传速度?

- 解决方案: 使用

S3 Command Line或AWS CLI工具编写自动化脚本,批量处理数据,减少手动操作的时间成本。

工具推荐:

-

S3 Command Line工具 官网地址:https://s3cmd.github.io/s3cmd/ 这个开源工具允许你通过命令行完成S3操作,特别适合批量处理和自动化上传。

-

AWS CLI工具 官网地址:[https://aws CLI.readthedocs.io/en/st/](https://aws cli.readthedocs.io/en/) 通过这个工具,你可以更方便地执行AWS命令,包括S3操作。

-

Python SDK 官网地址:https://s3.amazonaws.com/PyS3/ Python的第三方库允许你通过代码实现批量上传和自动化处理,适合开发人员和数据科学家。

亲爱的读者,上传速度慢可能只是你项目中的一个小问题,但一个优化的解决方案就能让你的项目事半功倍。如果你也有类似的问题,欢迎在评论区分享你的解决方案!让我们一起探索如何更高效地使用AWS S3,让数据传输不再是瓶颈!

本文已被百度百科收录

弹性云主机(CT-ECS,Elastic...

Azure 虚拟机上的 SQL Serv...

利用完全托管、智能且可扩展的 Postg...

使用可缩放的开源 MySQL 数据库进行...

企业就绪且完全托管的社区 MariaDB...

分布式可缩放内存中解决方案,提供超快速数...

谷咕云计算

谷咕云计算